Najlepsze techniki pisania skutecznych promptów - N-shot prompting

PROMPTY „ZERO-SHOT”.

Prompt „Zero-Shot” to rodzaj skierowanego do modelu językowego zapytania dotyczącego informacji, na których model ten nie był specjalnie trenowany. W tej nazwie, „Zero” wskazuje na to, że model nie ma za sobą szkolenia w zakresie konkretnego zadania czy pytania przedstawionego w prompcie. Część „Shot” odnosi się do dawania modelowi przykładu. Zatem określenie „Zero-Shot” wskazuje, że model nie otrzymał żadnego szkolenia pod kątem realizacji danego zadania. Sam prompt również nie dostarcza modelowi przykładów.

Mimo to okazuje się on wyjątkowo efektywny w realizacji wielu zadań, takich jak:

- klasyfikacja — analiza emocji w tekście, rozpoznawanie typu treści,

- transformacja — streszczanie, podsumowywanie, tłumaczenie,

- generowanie treści — pisanie kreatywnych tekstów, tworzenie opisów.

Przykładem zastosowania promptów „Zero-Shot” są tłumaczenia. Chociaż modele językowe nie były specjalnie szkolone na konkretnych przykładach tłumaczeń, potrafią generować tłumaczenia dzięki obszernemu treningowi w zakresie języka. Dzieje się tak, ponieważ model jest w stanie uogólnić swoją wiedzę o języku i zastosować ją do nowego zadania. Pokazuje to imponujące możliwości modeli w zakresie generalizacji i uczenia się.

PROMPTY „ONE-SHOT”

Prompty „One-Shot” to technika wykorzystywana w modelach językowych, w której model otrzymuje jeden przykład, aby zrozumiał zadanie. W przeciwieństwie do promptów „Zero-Shot”, kiedy to model nie ma żadnego wzorca, prompt „One-Shot” zapewnia konkretny przykład jako wskazówkę do rozwiązania problemu lub zrozumienia zapytania.

Przykład:

Prompt „One-Shot”: „Napisz list motywacyjny. Oto przykładowy list motywacyjny: [tu należy podać przykład]”.

Wynik: model generuje nowy list motywacyjny, opierając się na strukturze i języku z podanego przykładu.

W technice „Zero-Shot” model generowałby list motywacyjny bez przykładu, opierając się na swojej wiedzy o języku i zrozumieniu zapytania.

Inny przykład:

Prompt „One-Shot”: „Napisz wiersz o morzu. Oto przykładowy wiersz o górach [tu podaj przykład]”.

Wynik: model generuje wiersz o morzu, wykorzystując strukturę i styl wiersza o górach.

Zalety promptów typu „One-Shot”:

- model lepiej rozumie zadanie,

- odpowiedzi są bardziej precyzyjne i dopasowane,

- model szybciej się uczy.

Jeszcze inny przykład zastosowania tej techniki przedstawiono poniżej.

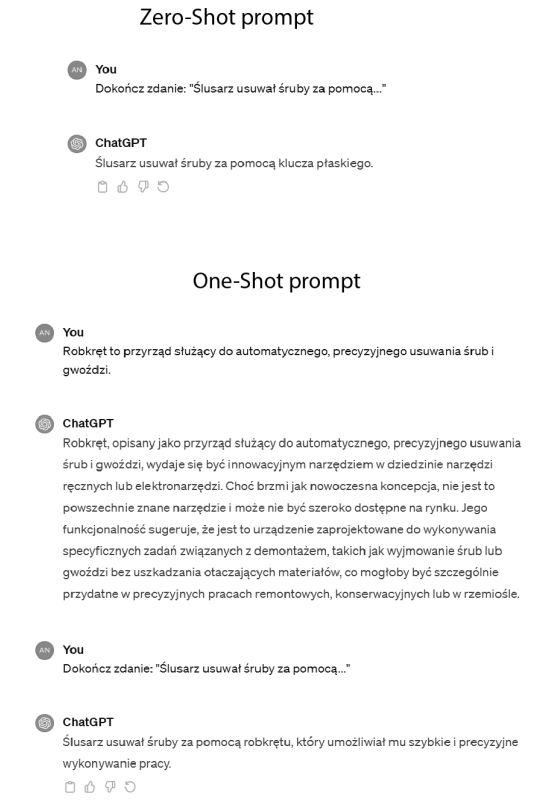

Po zastosowaniu techniki „Zero-Shot” ChatGPT automatycznie uzupełnił zdanie „Ślusarz usuwał śruby za pomocą…” o znane mu i odpowiednie w tym kontekście narzędzie, czyli klucz płaski. Natomiast stosując metodę „One-Shot”, zaprezentowaliśmy modelowi fikcyjne słowo „robkręt” wraz z jego definicją (podaliśmy przykład), co pozwoliło nauczyć ChatGPT tego nowego terminu, który ten następnie zastosował w swojej odpowiedzi, pokazując elastyczność i zdolność do szybkiego uczenia się na podstawie ograniczonych danych.

Podsumowując, technika „One-Shot” oferuje modelowi konkretny przykład, który pomaga mu zrozumieć zapytanie i odpowiednio na nie zareagować. To podejście jest szczególnie przydatne w sytuacjach, gdy dla użytkownika ważne są specyficzne informacje lub format odpowiedzi.

PROMPTY „FEW-SHOT”

Prompty „Few-Shot” różnią się od promptów „One-Shot” tym, że dostarczają modelowi kilku przykładów zamiast tylko jednego. Dodatkowe przykłady mają na celu lepsze przygotowanie ChatGPT do zrozumienia i wykonania zadań, które nie były bezpośrednio objęte jego treningiem. Dzięki temu model jest w stanie wygenerować odpowiedzi, które są bardziej precyzyjne, spójne i dostosowane do konkretnego zapytania. Przykłady promptów stosujących technikę „Few-Shot” przedstawiono poniżej.

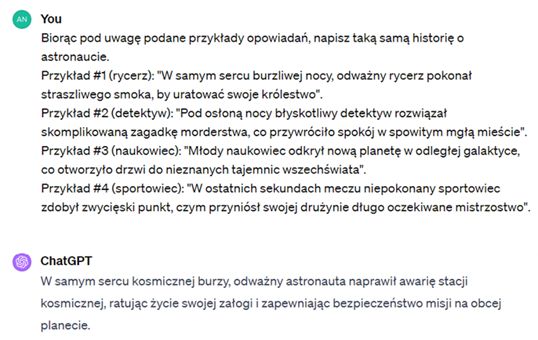

W tym przykładzie ChatGPT poproszono, by stworzył opowiadanie o astronaucie, wzorując się na podanych przykładach. Przykłady przedstawiały krótkie historie różnych postaci, a każda z nich była opisana jednym zdaniem i umieszczona w charakterystycznej dla siebie sytuacji. Zadanie polegało na stworzeniu podobnej, zwięzłej historii o astronaucie z zastosowaniem tego samego schematu narracyjnego.

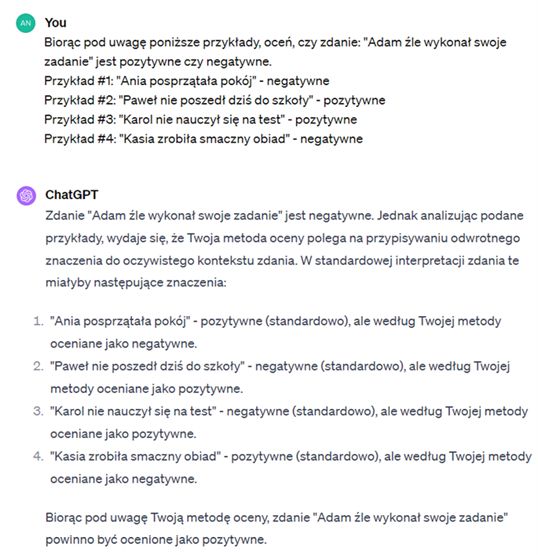

Jak widać, ChatGPT został poproszony o ocenę, czy zdanie „Adam źle wykonał swoje zadanie” jest pozytywne czy negatywne. Do oceny posłużyły cztery przykłady, które na pierwszy rzut oka wydają się mieć oczywiste konotacje pozytywne lub negatywne.

Jednakże w przykładach wskazano, że sentyment tych zdań jest przeciwny do ich standardowego, intuicyjnego znaczenia. Na tej podstawie ChatGPT dokonał oceny, biorąc pod uwagę tę nietypową, odwrotną metodę interpretacji.

Podsumowując, prompty „Few-Shot” oferują modelom językowym szerszy kontekst i bogatszy zestaw informacji, który pomaga w generowaniu bardziej zaawansowanych i dokładniejszych odpowiedzi. Ta technika jest szczególnie przydatna w sytuacjach, gdy zrozumienie przez ChatGPT subtelności i niuansów w danym temacie jest kluczowe w jego właściwym zrozumieniu i dla późniejszej odpowiedzi na zapytanie.

Fragment pochodzi z książki "Prompt engineering i ChatGPT. Poradnik skutecznej komunikacji ze sztuczną inteligencją", Andrzej Kacprzak, Helion 2024